학습의 흐름과 단계별 접근

- 기초 개념 습득: 1부에서는 인공지능의 기본 개념과 역사, 그리고 인공지능을 이해하는 데 필요한 기초 수학과 통계 지식을 다룹니다. 이를 통해 독자들은 인공지능의 전반적인 그림을 이해하고, 이후 장에서 다룰 내용을 준비합니다.

- 머신러닝 이론 및 실습: 2부에서는 머신러닝의 주요 알고리즘과 데이터 전처리 방법을 학습합니다. 지도 학습과 비지도 학습을 이해하고, 실제 데이터를 사용하여 모델을 구현하고 평가하는 과정을 통해 실질적인 머신러닝 기술을 습득합니다.

- 딥러닝 심화: 3부에서는 딥러닝의 기본 개념과 주요 프레임워크를 학습합니다. CNN과 RNN을 다루며, 이를 실제로 구현해보는 실습을 통해 딥러닝의 심화된 내용을 배웁니다.

- 실전 프로젝트 경험: 4부에서는 실제 프로젝트를 통해 배운 내용을 적용합니다. 이미지 분류, 자연어 처리, 강화 학습 등 다양한 분야의 프로젝트를 통해 실전 경험을 쌓고, 문제 해결 능력을 키웁니다.

- 윤리적 문제와 미래 전망 이해: 5부에서는 인공지능의 윤리적 문제와 미래 전망을 다룹니다. 이를 통해 독자들은 기술적 지식뿐만 아니라, 인공지능의 사회적 영향과 윤리적 고려 사항에 대해서도 이해하게 됩니다.

이러한 단계별 접근 방식을 통해 독자들은 이론과 실습을 균형 있게 학습하며, 인공지능의 기초부터 실전까지 체계적으로 이해하고 적용할 수 있는 능력을 갖추게 됩니다.

목차

서문

- 인공지능이란 무엇인가?

- 이 책의 목표와 학습 방법

- 독자 대상

- 책의 구성

1부: 인공지능 기초

1장: 인공지능 소개

- 인공지능의 정의와 역사

- 인공지능의 현재와 미래

- 인공지능의 다양한 응용 분야

2장: 기초 개념 이해하기

- 머신러닝, 딥러닝, 신경망의 기본 개념

- 데이터의 중요성

- 지도 학습과 비지도 학습

3장: 필수 수학 및 통계

- 선형대수 기초

- 미적분 기초

- 확률과 통계 개념

2부: 머신러닝의 세계

4장: 데이터 전처리

- 데이터 수집 및 정제

- 데이터 시각화

- 특성 공학

5장: 지도 학습 알고리즘

- 회귀 분석

- 분류 알고리즘 (k-NN, 결정 트리, 랜덤 포레스트, SVM 등)

- 모델 평가와 성능 향상 기법

6장: 비지도 학습 알고리즘

- 군집화 (k-평균, 계층적 군집화)

- 차원 축소 (PCA, t-SNE)

7장: 모델 평가 및 선택

- 교차 검증

- 과적합과 과소적합

- 하이퍼파라미터 튜닝

3부: 딥러닝의 세계

8장: 신경망의 기본

- 퍼셉트론과 다층 퍼셉트론

- 활성화 함수

- 역전파 알고리즘

9장: 딥러닝 프레임워크

- 텐서플로우 소개

- 파이토치 소개

- 기본 사용법 및 예제

10장: 합성곱 신경망 (CNN)

- CNN의 구조와 원리

- 이미지 처리 응용

- 대표적인 CNN 모델들 (LeNet, AlexNet, VGG 등)

11장: 순환 신경망 (RNN)

- RNN의 구조와 원리

- 시계열 데이터 처리

- LSTM과 GRU

4부: 실전 프로젝트

12장: 프로젝트 1 – 이미지 분류

- 데이터셋 소개 (CIFAR-10 등)

- 모델 설계 및 구현

- 성능 평가 및 개선

13장: 프로젝트 2 – 자연어 처리

- 텍스트 데이터 전처리

- 감성 분석 모델 구현

- 결과 분석

14장: 프로젝트 3 – 강화 학습

- 강화 학습의 기본 개념

- 간단한 게임 AI 구현

- 성능 향상 기법

5부: 인공지능의 윤리와 미래

15장: 인공지능의 윤리적 문제

- 개인정보 보호

- 알고리즘의 편향성

- AI와 일자리

16장: 인공지능의 미래 전망

- 최신 연구 동향

- 미래의 기술 발전 가능성

- 인공지능의 사회적 영향

부록

- 추가 학습 자료

- 추천 도서 및 온라인 강의

- AI 커뮤니티 참여 방법

서문

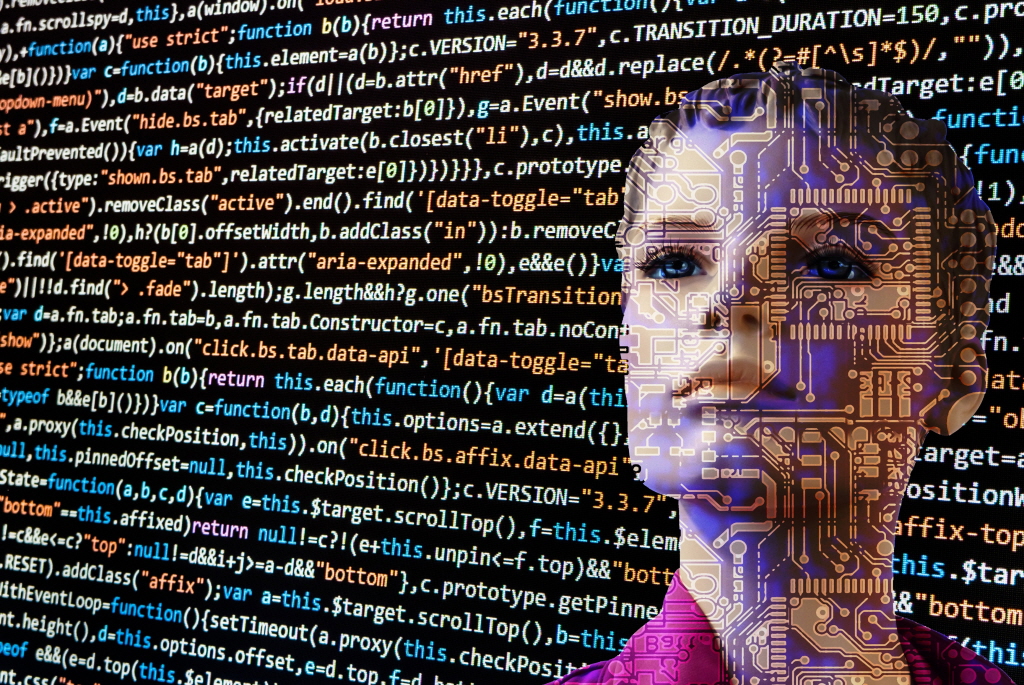

인공지능이란 무엇인가?

인공지능의 정의

인공지능(AI, Artificial Intelligence)은 인간의 지능을 모방하거나 이를 넘어서는 능력을 컴퓨터 시스템이 갖추도록 하는 기술과 학문 분야를 의미합니다. 인공지능은 문제 해결, 학습, 추론, 인식, 언어 이해 등의 작업을 수행할 수 있는 시스템을 개발하는 것을 목표로 합니다.

- 협의의 인공지능: 특정 작업을 수행하기 위해 설계된 시스템 (예: 체스 프로그램, 음성 인식 시스템).

- 광의의 인공지능: 인간과 유사한 수준의 종합적 지능을 가진 시스템.

인공지능의 목적과 목표

인공지능의 목적은 복잡하고 다양한 문제를 해결하기 위해 인간의 지능적 능력을 모방하거나 이를 확장하는 것입니다. 주된 목표는 다음과 같습니다:

- 자동화: 반복적이고 시간이 많이 소요되는 작업을 자동화하여 효율성을 높이는 것.

- 의사 결정 지원: 방대한 데이터 분석을 통해 더 나은 의사 결정을 내릴 수 있도록 지원하는 것.

- 문제 해결: 복잡한 문제를 해결하기 위한 새로운 알고리즘과 모델 개발.

- 인간의 한계 극복: 인간이 처리하기 어려운 대규모 데이터나 복잡한 문제를 해결.

인공지능의 역사와 발전 과정

인공지능의 역사는 수십 년에 걸친 연구와 개발의 결과로 형성되었습니다. 주요 발전 과정을 요약하면 다음과 같습니다:

- 1950년대: AI라는 용어가 처음 등장하고 초기 연구가 시작됨. 앨런 튜링의 튜링 테스트 제안.

- 1960~1970년대: 기본적인 알고리즘과 이론이 개발됨. 예를 들어, 초기의 신경망 모델과 탐색 알고리즘.

- 1980년대: 전문가 시스템과 같은 지식 기반 시스템의 발전. 프로그래밍 언어 Prolog와 Lisp 사용.

- 1990년대: 기계 학습 알고리즘의 발전과 데이터 마이닝 기술의 등장.

- 2000년대: 빅데이터와 고성능 컴퓨팅의 발전으로 딥러닝의 부상.

- 2010년대 이후: 딥러닝을 기반으로 한 다양한 응용 프로그램의 성공. 이미지 인식, 음성 인식, 자연어 처리 등의 성과.

인공지능의 다양한 형태와 적용 사례

인공지능은 다양한 형태로 존재하며, 여러 산업 분야에서 적용되고 있습니다. 주요 형태와 사례는 다음과 같습니다:

- 기계 학습(Machine Learning): 데이터를 기반으로 학습하여 예측 모델을 만드는 기술. 예: 스팸 필터링, 추천 시스템.

- 딥러닝(Deep Learning): 인공 신경망을 사용한 심층 학습 기술. 예: 이미지 인식, 음성 인식.

- 자연어 처리(NLP): 인간의 언어를 이해하고 처리하는 기술. 예: 챗봇, 자동 번역 시스템.

- 컴퓨터 비전(Computer Vision): 이미지나 동영상을 분석하여 의미 있는 정보를 추출하는 기술. 예: 자율 주행차, 얼굴 인식 시스템.

- 로보틱스(Robotics): 로봇을 설계하고 제어하는 기술. 예: 제조업에서의 자동화 로봇, 의료용 로봇.

- 강화 학습(Reinforcement Learning): 환경과 상호작용하며 학습하는 기술. 예: 게임 AI, 자율 주행.

이러한 기술들은 의료, 금융, 제조, 교통, 교육 등 다양한 산업 분야에서 혁신적인 변화를 가져오고 있습니다. AI는 현재와 미래의 사회에서 중요한 역할을 수행하며, 인간의 삶을 더욱 편리하고 효율적으로 만들어주는 중요한 도구가 되고 있습니다.

이 책의 목표와 학습 방법

이 책을 통해 얻을 수 있는 학습 목표

이 책은 독자들이 인공지능(AI)의 기초부터 실전까지 체계적으로 학습할 수 있도록 돕는 것을 목표로 합니다. 구체적인 학습 목표는 다음과 같습니다:

- 기초 개념 이해: 인공지능의 기본 개념과 역사, 주요 용어를 이해하고 설명할 수 있다.

- 기초 수학 및 통계 능력 향상: 인공지능 알고리즘을 이해하는 데 필요한 기본 수학과 통계 개념을 습득한다.

- 머신러닝 이해 및 적용: 머신러닝의 주요 알고리즘과 모델을 이해하고, 이를 실제 데이터에 적용할 수 있다.

- 딥러닝 이해 및 구현: 딥러닝의 기본 개념과 주요 프레임워크를 이해하고, 간단한 딥러닝 모델을 구현할 수 있다.

- 실전 프로젝트 경험: 실제 프로젝트를 통해 AI 모델을 설계하고 구현하며, 데이터 전처리부터 모델 평가까지의 전 과정을 경험한다.

- AI 윤리 및 미래 전망 이해: AI의 윤리적 문제와 미래 전망을 이해하고, 이에 대한 자신의 의견을 정리할 수 있다.

이 책의 구조와 학습 방법

이 책은 총 다섯 부분으로 나누어져 있으며, 각 부분은 단계별로 학습 목표를 달성할 수 있도록 구성되어 있습니다:

- 1부: 인공지능 기초: AI의 기본 개념과 역사, 필수 수학 및 통계 지식을 소개합니다.

- 2부: 머신러닝의 세계: 머신러닝의 주요 알고리즘과 데이터 전처리 기법을 학습합니다.

- 3부: 딥러닝의 세계: 딥러닝의 기본 개념과 주요 프레임워크, CNN과 RNN을 학습합니다.

- 4부: 실전 프로젝트: 실제 데이터를 사용하여 AI 모델을 설계, 구현, 평가하는 실전 프로젝트를 진행합니다.

- 5부: 인공지능의 윤리와 미래: AI의 윤리적 문제와 미래 전망을 다룹니다.

각 부분은 이론과 실습을 균형 있게 포함하여 학습자의 이해를 돕습니다.

실습과 이론의 균형 잡힌 접근 방식

이 책은 이론과 실습을 균형 있게 제공하여 학습자의 이해와 응용 능력을 동시에 향상시킵니다:

- 이론적 학습: 각 장에서 다루는 주요 개념과 알고리즘에 대한 이론적 설명을 제공합니다. 수학적 개념, 알고리즘의 원리, 적용 사례 등을 상세히 설명합니다.

- 실습: 각 장의 이론을 실제로 적용해볼 수 있는 실습 예제를 제공합니다. Python을 사용하여 코딩 실습을 진행하며, 주요 AI 프레임워크(예: TensorFlow, PyTorch)를 활용합니다.

- 연습 문제: 각 장의 끝에는 이론과 실습을 복습할 수 있는 연습 문제와 퀴즈가 포함되어 있습니다. 이를 통해 학습한 내용을 점검하고 이해도를 높일 수 있습니다.

- 프로젝트 기반 학습: 4부에서는 실제 데이터를 사용한 프로젝트를 통해 실전 경험을 쌓을 수 있도록 합니다. 이미지 분류, 자연어 처리, 강화 학습 등의 프로젝트를 통해 실전에서의 문제 해결 능력을 배양합니다.

- 참고 자료: 각 장의 끝에는 추가 학습을 위한 참고 자료와 추천 도서를 제공합니다. 이를 통해 독자들은 더욱 심화된 학습을 할 수 있습니다.

이러한 접근 방식을 통해 독자들은 인공지능의 기초부터 실전까지 체계적으로 학습하고, 실제 문제를 해결할 수 있는 능력을 키울 수 있습니다.

독자 대상

이 책의 대상 독자층

이 책은 인공지능(AI)에 관심이 있는 모든 독자를 대상으로 합니다. 특히 다음과 같은 독자층을 염두에 두고 작성되었습니다:

- AI 초보자: 인공지능의 기본 개념부터 차근차근 배우고 싶은 사람.

- 프로그래밍 입문자: Python을 처음 접하는 초보 프로그래머.

- 데이터 과학자 지망생: 데이터 분석과 머신러닝에 관심이 있는 사람.

- AI 연구자 및 개발자: 기초를 다지고 실전 프로젝트를 통해 경험을 쌓고자 하는 사람.

- 학생 및 교육자: AI를 공부하거나 가르치는 학생과 교사.

- 직장인 및 업계 종사자: AI를 업무에 적용하고자 하는 직장인과 산업 종사자.

선행 지식 요구 사항

이 책은 다음과 같은 기본적인 지식을 가지고 있는 독자를 대상으로 합니다:

- 기본 프로그래밍 지식: Python을 사용하여 간단한 프로그램을 작성할 수 있는 능력.

- 변수, 조건문, 반복문, 함수 등의 기본 개념 이해.

- 기본 수학 및 통계 지식: 고등학교 수준의 수학과 통계 지식.

- 선형대수, 미적분, 확률과 통계의 기초 개념 이해.

초보자도 충분히 따라올 수 있도록 필요한 기초 개념을 책에서 상세히 설명할 예정이므로, 선행 지식이 부족한 독자도 학습할 수 있습니다.

학습 준비 사항

이 책을 효과적으로 학습하기 위해 다음과 같은 준비 사항을 갖추는 것이 좋습니다:

- 필요한 소프트웨어 및 도구:

- Python 설치: 최신 버전의 Python을 설치합니다.

- Jupyter Notebook: 코딩 실습을 위한 Jupyter Notebook 설치 (Anaconda 배포판 권장).

- AI 프레임워크: TensorFlow와 PyTorch 설치 (책에서 설치 방법 안내).

- 필요한 하드웨어:

- 컴퓨터: 기본적인 사양의 컴퓨터 (CPU 또는 GPU 사용 가능).

- 인터넷 연결: 온라인 자료와 데이터를 다운로드하기 위한 안정적인 인터넷 연결.

- 학습 자료:

- 책 본문: 각 장의 내용을 이해하고, 이론과 실습을 균형 있게 학습.

- 실습 코드: 책에서 제공하는 예제 코드를 다운로드하여 실행.

- 참고 자료: 각 장 끝에 제공되는 추가 학습 자료와 추천 도서 참고.

이 책을 학습하는 동안, 독자들은 필요한 소프트웨어를 설치하고 설정하는 방법을 배울 것이며, 각 장에서 다루는 이론과 실습을 통해 인공지능에 대한 깊이 있는 이해와 실제 구현 능력을 갖추게 될 것입니다.

1부: 인공지능 기초

1장: 인공지능 소개

1. 인공지능의 정의와 기본 개념

- 정의: 인공지능(Artificial Intelligence, AI)은 컴퓨터 시스템이 인간의 지능적인 행동을 모방하거나 이를 초과하는 능력을 갖추도록 하는 기술을 의미합니다. 이는 학습, 추론, 문제 해결, 언어 이해, 인식 등 다양한 능력을 포함합니다.

- 기본 개념:

- 기계 학습(Machine Learning): 데이터를 기반으로 패턴을 학습하고 예측을 수행하는 알고리즘.

- 딥러닝(Deep Learning): 인공 신경망을 활용한 심층 학습 기술.

- 자연어 처리(NLP): 인간의 언어를 이해하고 생성하는 기술.

- 컴퓨터 비전(Computer Vision): 이미지와 비디오를 분석하고 이해하는 기술.

2. 인공지능의 역사: 초창기부터 현대까지

- 1950년대:

- 앨런 튜링이 AI의 가능성을 제안하고 튜링 테스트를 소개.

- 다트머스 회의(1956): “인공지능”이라는 용어가 처음 사용됨.

- 1960~1970년대:

- 초기 AI 연구의 발전과 함께 첫 번째 AI 붐.

- 전문가 시스템과 같은 규칙 기반 AI 시스템 개발.

- 1980~1990년대:

- 전문가 시스템의 한계로 인해 AI 연구의 겨울기.

- 기계 학습 알고리즘의 발전과 함께 데이터 마이닝의 등장.

- 2000년대:

- 빅데이터와 고성능 컴퓨팅의 발전으로 AI 연구 부활.

- 딥러닝 기술의 부상과 함께 이미지 인식, 음성 인식 등의 분야에서 큰 성과.

- 2010년대 이후:

- 딥러닝을 기반으로 한 다양한 AI 응용 프로그램의 성공.

- 자율주행차, 음성 비서, 번역 시스템 등에서의 혁신.

3. 현재의 인공지능 기술과 그 응용

- 기계 학습 및 딥러닝: 추천 시스템(예: 넷플릭스, 유튜브), 금융 예측, 의료 진단.

- 자연어 처리: 챗봇(예: 아마존 알렉사, 구글 어시스턴트), 자동 번역(구글 번역), 텍스트 분석.

- 컴퓨터 비전: 자율주행차, 얼굴 인식 시스템, 의료 이미지 분석.

- 로보틱스: 제조업 자동화 로봇, 물류 로봇, 가정용 로봇(예: 로봇 청소기).

- 강화 학습: 게임 AI(예: 알파고), 자율주행, 산업 제어 시스템.

4. 인공지능의 미래와 전망

- 기술 발전:

- 자율 시스템: 완전한 자율주행차, 자율 비행 드론.

- 의료 혁신: 맞춤형 치료, 예측적 의료 진단.

- 스마트 시티: 교통 관리, 에너지 효율화, 스마트 그리드.

- 사회적 영향:

- 일자리 변화: 자동화로 인한 일자리 변화와 새로운 직업 창출.

- 교육: AI 기반 맞춤형 학습, 교육 접근성 확대.

- 윤리 및 규제: AI의 윤리적 문제, 프라이버시 보호, 공정성 보장.

- 미래 전망:

- 인공지능의 지속적인 발전: AI 연구와 기술 개발이 계속되며, 더 많은 분야에서 AI의 응용이 확대될 것으로 전망됩니다.

- 인간과 AI의 협업: 인간의 능력을 보완하고 확장하는 AI 기술의 발전으로, 더 나은 의사결정과 문제 해결이 가능해질 것입니다.

- 새로운 기회와 도전: AI의 발전은 새로운 기회를 창출하는 동시에, 윤리적 문제와 같은 새로운 도전을 제기할 것입니다.

이 장에서는 인공지능의 기본 개념과 정의, 역사적 발전 과정, 현재의 기술과 응용, 그리고 미래 전망에 대해 종합적으로 다루며, 독자들이 인공지능의 전반적인 흐름을 이해하고 앞으로의 학습을 위한 기초를 다질 수 있도록 합니다.

2장: 기초 개념 이해하기

1. 머신러닝과 딥러닝의 차이점

- 머신러닝 (Machine Learning):

- 정의: 머신러닝은 데이터에서 패턴을 학습하고 예측 모델을 생성하는 알고리즘의 집합입니다. 기계 학습 알고리즘은 명시적인 프로그래밍 없이 데이터로부터 학습할 수 있습니다.

- 알고리즘 예시: 회귀 분석, 결정 트리, 서포트 벡터 머신(SVM), k-최근접 이웃(k-NN), 랜덤 포레스트 등.

- 특징: 특징 추출 및 선택 과정이 수작업으로 이루어질 수 있으며, 비교적 적은 데이터로도 학습이 가능합니다.

- 딥러닝 (Deep Learning):

- 정의: 딥러닝은 다층 신경망을 사용하여 데이터로부터 자동으로 특징을 추출하고 학습하는 기계 학습의 하위 분야입니다.

- 알고리즘 예시: 인공 신경망(ANN), 합성곱 신경망(CNN), 순환 신경망(RNN), LSTM, GAN 등.

- 특징: 다량의 데이터를 처리하며, 특징 추출을 자동으로 수행합니다. 일반적으로 GPU를 사용하여 연산을 가속화합니다.

2. 신경망의 기본 개념과 구조

- 뉴런 (Neuron): 생물학적 뉴런에서 영감을 얻은 기본 단위. 입력 값을 받아 가중치를 곱하고, 활성화 함수를 통해 출력 값을 생성합니다.

- 퍼셉트론 (Perceptron): 가장 간단한 형태의 신경망으로, 하나의 뉴런으로 구성됩니다. 단층 퍼셉트론은 선형 분류 문제를 해결할 수 있습니다.

- 다층 신경망 (Multilayer Neural Network): 입력층, 은닉층, 출력층으로 구성된 신경망. 은닉층이 여러 개일수록 더 복잡한 패턴을 학습할 수 있습니다.

- 활성화 함수 (Activation Function): 뉴런의 출력을 비선형 변환하는 함수. 예: 시그모이드(sigmoid), ReLU(Rectified Linear Unit), 타나(Tanh).

- 역전파 (Backpropagation): 오차를 역전파하여 가중치를 업데이트하는 학습 알고리즘. 경사 하강법(Gradient Descent)을 사용합니다.

3. 데이터의 중요성과 데이터 사이언스

- 데이터의 중요성:

- 학습의 기초: 데이터는 머신러닝과 딥러닝 모델의 학습과 평가에 필수적입니다.

- 데이터 품질: 데이터의 품질은 모델의 성능에 직접적인 영향을 미칩니다. 잘 정제된 데이터는 모델의 예측력을 높입니다.

- 데이터 양: 충분한 양의 데이터가 있어야 딥러닝 모델이 효과적으로 학습할 수 있습니다.

- 데이터 사이언스:

- 정의: 데이터로부터 통찰력을 얻기 위해 과학적 방법, 프로세스, 알고리즘, 시스템을 사용하는 학문.

- 주요 단계: 데이터 수집, 데이터 정제, 탐색적 데이터 분석(EDA), 데이터 시각화, 모델링, 결과 해석.

- 도구 및 기술: Python, R, SQL, Hadoop, Spark, Tableau, Pandas, Numpy, Matplotlib 등.

4. 지도 학습과 비지도 학습의 이해

- 지도 학습 (Supervised Learning):

- 정의: 입력 데이터와 정답(label)이 있는 데이터를 사용하여 모델을 학습합니다.

- 목표: 새로운 입력 데이터에 대한 예측을 수행.

- 알고리즘 예시: 회귀 분석(예: 선형 회귀, 다항 회귀), 분류(예: 로지스틱 회귀, SVM, 결정 트리, 랜덤 포레스트, k-NN).

- 응용 분야: 스팸 필터링, 이미지 분류, 음성 인식, 의료 진단.

- 비지도 학습 (Unsupervised Learning):

- 정의: 정답(label) 없이 입력 데이터의 패턴을 학습합니다.

- 목표: 데이터의 구조를 발견하고 그룹화하거나 차원을 축소.

- 알고리즘 예시: 군집화(예: k-평균, 계층적 군집화, DBSCAN), 차원 축소(예: PCA, t-SNE).

- 응용 분야: 고객 세분화, 이상 탐지, 데이터 시각화, 이미지 압축.

이 장에서는 인공지능의 기초 개념을 이해하는 데 필요한 핵심 주제들을 다루며, 독자들이 인공지능의 다양한 접근 방식을 이해하고 앞으로의 학습을 준비할 수 있도록 돕습니다.

3장: 필수 수학 및 통계

1. 선형대수 기초: 벡터와 행렬

- 벡터 (Vector):

- 정의: 크기와 방향을 가지는 수학적 객체로, n차원 공간에서 n개의 성분을 가진다.

- 벡터 연산: 덧셈, 뺄셈, 스칼라 곱, 내적, 외적.

- 응용: 데이터 포인트를 벡터로 표현, 특징 벡터, 거리 계산 (예: 유클리드 거리).

- 행렬 (Matrix):

- 정의: 수나 기호를 직사각형 모양으로 배열한 것, m x n 크기의 행렬은 m개의 행과 n개의 열로 구성.

- 행렬 연산: 덧셈, 뺄셈, 곱셈, 전치, 역행렬.

- 응용: 선형 변환, 데이터 변환, 공분산 행렬, 이미지 변환 (예: 회전, 스케일링).

- 행렬 분해:

- 특잇값 분해(SVD): 행렬을 세 개의 행렬로 분해하여 데이터를 축소하거나 노이즈를 제거하는 데 사용.

- 고유값 분해: 행렬을 고유값과 고유벡터로 분해하여 데이터의 주요 구성 요소를 이해하는 데 사용.

2. 미적분 기초: 미분과 적분

- 미분 (Differentiation):

- 정의: 함수의 변화율을 나타내는 개념으로, 기울기를 계산.

- 기본 법칙: 합, 곱, 몫의 미분, 체인 룰.

- 응용: 경사 하강법에서 손실 함수의 최솟값을 찾기 위해 기울기 계산, 뉴런의 활성화 함수의 변화율 계산.

- 적분 (Integration):

- 정의: 함수의 누적된 값을 나타내는 개념으로, 면적을 계산.

- 기본 법칙: 정적분, 부정적분, 치환 적분, 부분 적분.

- 응용: 확률 밀도 함수의 누적 분포 계산, 연속 확률 변수의 기대값 계산.

3. 확률과 통계: 확률 분포와 통계적 추론

- 확률 (Probability):

- 기본 개념: 사건, 확률 공간, 조건부 확률, 독립 사건.

- 확률 분포: 이산 확률 분포(예: 베르누이 분포, 이항 분포), 연속 확률 분포(예: 정규 분포, 지수 분포).

- 기댓값과 분산: 확률 변수의 평균과 분포의 퍼짐 정도.

- 통계 (Statistics):

- 기술 통계: 데이터 요약 (평균, 중앙값, 표준 편차).

- 추론 통계: 표본에서 모집단에 대한 결론 도출 (가설 검정, 신뢰 구간).

- 회귀 분석: 두 변수 간의 관계 모델링 (단순 회귀, 다중 회귀).

- 통계적 추론: 표본 데이터로부터 모집단의 특성을 추정 (점 추정, 구간 추정).

4. 머신러닝에 필요한 수학적 개념

- 최적화 (Optimization):

- 목적 함수: 최소화 또는 최대화해야 하는 함수.

- 경사 하강법 (Gradient Descent): 목적 함수의 최솟값을 찾는 방법. 학습률, 배치 경사 하강법, 확률적 경사 하강법.

- 정규화: 과적합 방지를 위한 규제 기법 (L1, L2 정규화).

- 선형 대수와 머신러닝:

- 벡터 공간: 특징 공간에서의 데이터 표현.

- 고유값 문제: 차원 축소 기법 (PCA)에서의 고유벡터와 고유값.

- 행렬 분해: 추천 시스템에서의 행렬 분해 활용 (예: SVD, 행렬 인수분해).

- 확률과 머신러닝:

- 확률 분포: 데이터의 확률 분포 모델링.

- 베이즈 정리: 조건부 확률 계산, 베이지안 네트워크.

- 최대우도추정 (MLE): 모델 파라미터 추정.

- 미적분과 머신러닝:

- 기울기 계산: 신경망 학습에서의 역전파 알고리즘.

- 로지스틱 회귀: 시그모이드 함수와 손실 함수의 미분.

이 장에서는 머신러닝과 딥러닝을 이해하고 효과적으로 적용하기 위해 필요한 수학적 기초를 다룹니다. 벡터와 행렬, 미분과 적분, 확률과 통계의 기본 개념을 학습하고, 이를 머신러닝에 어떻게 활용하는지 이해함으로써 독자들이 이론적 배경을 튼튼히 다질 수 있도록 합니다.

2부: 머신러닝의 세계

4장: 데이터 전처리

1. 데이터 수집 방법

- 정형 데이터 수집:

- 데이터베이스: SQL을 사용한 관계형 데이터베이스에서 데이터 추출.

- 스프레드시트: CSV, Excel 파일 등으로부터 데이터 불러오기.

- 웹 스크래핑: BeautifulSoup, Scrapy, Selenium 등을 이용해 웹사이트로부터 데이터 수집.

- API: 공개된 API를 통해 실시간 데이터 수집 (예: Twitter API, Google Maps API).

- 비정형 데이터 수집:

- 텍스트 데이터: 웹페이지, 문서, 소셜 미디어 게시물 등.

- 이미지 및 비디오 데이터: 웹사이트, 카메라, 센서 등을 통해 수집.

- 오디오 데이터: 음성 녹음, 스트리밍 서비스에서 수집.

2. 데이터 정제 및 클리닝 기법

- 결측값 처리:

- 삭제: 결측값을 포함한 행이나 열 제거.

- 대체: 평균, 중앙값, 최빈값 등으로 결측값 대체.

- 예측: 다른 변수들을 사용하여 결측값 예측.

- 이상값 처리:

- 탐지: 박스 플롯, Z-스코어, IQR(Interquartile Range) 등을 사용한 이상값 탐지.

- 처리: 삭제, 대체, 수정.

- 중복 데이터 처리:

- 탐지: 중복 행 탐지.

- 처리: 중복 행 제거.

- 데이터 형식 변환:

- 타입 변환: 숫자형, 문자열, 날짜 형식 변환.

- 스케일링 및 정규화: Min-Max 스케일링, Z-스코어 정규화 등으로 데이터 스케일 조정.

- 문자열 데이터 정제:

- 텍스트 정규화: 소문자 변환, 불용어 제거, 표제어 추출(lematization), 어간 추출(stemming).

- 토큰화: 문장을 단어 또는 문자 수준으로 분할.

3. 데이터 시각화 도구와 기법

- 데이터 시각화 도구:

- Matplotlib: 기본적인 플롯 생성, 다양한 커스터마이징 가능.

- Seaborn: 통계적 데이터 시각화에 적합한 고급 시각화 도구.

- Plotly: 대화형 그래프 생성 도구.

- Tableau: 대화형 데이터 시각화 및 비즈니스 인텔리전스 도구.

- Power BI: 마이크로소프트의 데이터 시각화 및 비즈니스 인텔리전스 도구.

- 기본 시각화 기법:

- 산점도 (Scatter Plot): 두 변수 간의 관계를 시각화.

- 선 그래프 (Line Plot): 시간에 따른 데이터 변화를 시각화.

- 막대 그래프 (Bar Plot): 범주형 데이터의 크기를 비교.

- 히스토그램 (Histogram): 데이터의 분포를 시각화.

- 박스 플롯 (Box Plot): 데이터의 분포와 이상값 시각화.

- 고급 시각화 기법:

- 히트맵 (Heatmap): 상관 관계 매트릭스 시각화.

- 페어 플롯 (Pair Plot): 여러 변수 간의 관계를 한 번에 시각화.

- 분포도 (Distribution Plot): 데이터 분포 및 밀도 시각화.

- 군집 시각화: 클러스터링 결과를 시각화 (t-SNE, PCA를 사용한 차원 축소).

4. 특성 공학: 특성 선택과 생성

- 특성 선택 (Feature Selection):

- 필터 방법: 분산 임계값, 상관 계수, 카이제곱 검정 등을 사용하여 특성 선택.

- 래퍼 방법: 전진 선택, 후진 제거, 단계적 선택.

- 임베디드 방법: LASSO, 릿지 회귀, 결정 트리 기반 방법 (예: 랜덤 포레스트 중요도).

- 특성 생성 (Feature Engineering):

- 기존 특성 변환: 로그 변환, 제곱근 변환, 다항식 특성 생성.

- 날짜 및 시간 특성: 연도, 월, 일, 요일, 시간 등으로 분리하여 새로운 특성 생성.

- 텍스트 데이터 특성: 텍스트 길이, 단어 빈도, TF-IDF (Term Frequency-Inverse Document Frequency).

- 상호작용 특성: 두 개 이상의 특성을 결합하여 새로운 특성 생성.

- 도메인 지식 활용: 특정 분야의 지식을 사용하여 유용한 특성 생성.

이 장에서는 데이터 전처리의 중요성과 다양한 기법을 다룹니다. 데이터 수집부터 정제, 시각화, 특성 공학까지의 과정을 통해 데이터의 품질을 높이고 모델의 성능을 향상시키는 방법을 학습합니다. 독자들은 실제 데이터를 다루는 데 필요한 실용적인 기술을 익히게 됩니다.

5장: 지도 학습 알고리즘 회귀 분석: 선형 회귀와 다항 회귀 분류 알고리즘: k-NN, 결정 트리, 랜덤 포레스트, SVM 모델 평가: 정확도, 정밀도, 재현율, F1 스코어 성능 향상 기법: 교차 검증과 그리드 서치ChatGPT

5장: 지도 학습 알고리즘

1. 회귀 분석: 선형 회귀와 다항 회귀

- 선형 회귀 (Linear Regression):

- 개념: 종속 변수와 하나 이상의 독립 변수 간의 선형 관계를 모델링하는 회귀 분석 기법.

- 모델: y = β0 + β1×1 + β2×2 + … + ε.

- 학습 알고리즘: 최소 제곱법을 사용하여 모델 파라미터(β)를 추정.

- 다항 회귀 (Polynomial Regression):

- 개념: 선형 회귀와 유사하지만, 독립 변수와 종속 변수 간의 비선형 관계를 모델링하는 회귀 분석 기법.

- 모델: y = β0 + β1×1 + β2x^2 + … + βnx^n + ε.

- 학습 알고리즘: 최소 제곱법을 사용하여 다항식의 차수에 따라 적절한 모델을 선택.

2. 분류 알고리즘: k-NN, 결정 트리, 랜덤 포레스트, SVM

- k-최근접 이웃 (k-NN, k-Nearest Neighbors):

- 개념: 새로운 데이터 포인트와 가장 가까운 k개의 이웃을 찾아 다수결 투표를 통해 분류하는 알고리즘.

- 하이퍼파라미터: 이웃의 개수(k).

- 특징: 간단하고 직관적인 알고리즘으로, 특정 가정 없이 다양한 문제에 적용 가능.

- 결정 트리 (Decision Tree):

- 개념: 의사 결정 규칙과 그 결과를 나타내는 트리 구조를 사용하여 데이터를 분류 또는 회귀하는 알고리즘.

- 학습 알고리즘: 정보 이득(Information Gain)이 최대화되도록 트리를 분할.

- 특징: 해석이 용이하고, 비선형 문제에도 적용 가능.

- 랜덤 포레스트 (Random Forest):

- 개념: 여러 개의 결정 트리를 만들고 그들의 다수결로 예측하는 앙상블 학습 기법.

- 학습 알고리즘: 각 트리는 부트스트랩 샘플링을 통해 데이터를 선택하고, 랜덤한 특성 집합을 사용하여 트리를 분할.

- 특징: 과적합을 줄이고 안정적인 예측 성능을 제공.

- 서포트 벡터 머신 (SVM, Support Vector Machine):

- 개념: 데이터를 고차원 공간으로 매핑하여 선형 분리 가능한 최적의 초평면을 찾는 알고리즘.

- 학습 알고리즘: 마진을 최대화하는 초평면을 찾는 최적화 문제를 푸는 방법.

- 특징: 선형 및 비선형 분류, 회귀, 이상 탐지에 사용되며, 커널 트릭을 통해 비선형 문제 해결 가능.

3. 모델 평가: 정확도, 정밀도, 재현율, F1 스코어

- 정확도 (Accuracy): 전체 예측 중 올바르게 분류된 비율.

- 정밀도 (Precision): 양성으로 예측한 것 중 실제로 양성인 비율.

- 재현율 (Recall): 실제 양성 중 모델이 양성으로 분류한 비율.

- F1 스코어 (F1 Score): 정밀도와 재현율의 조화 평균으로, 불균형한 클래스 분포를 갖는 데이터셋에서 모델 성능을 평가하는 데 유용.

4. 성능 향상 기법: 교차 검증과 그리드 서치

- 교차 검증 (Cross-Validation): 데이터를 여러 개의 부분 집합으로 나누어 모델을 반복적으로 학습하고 평가하는 기법.

- k-겹 교차 검증 (k-Fold Cross-Validation): 데이터를 k개의 폴드로 나누고, 각 반복에서 하나의 폴드를 검증 세트로 사용하고 나머지를 학습 세트로 사용.

- 그리드 서치 (Grid Search): 하이퍼파라미터 공간을 탐색하여 최적의 모델 파라미터를 찾는 기법.

- 하이퍼파라미터: 모델 학습 전에 사전에 설정되는 파라미터 (예: k-NN의 이웃 수, 결정 트리의 깊이).

이 장에서는 지도 학습 알고리즘을 소개하고, 각 알고리즘의 개념과 특징을 다룹니다. 또한 모델 평가 지표와 성능 향상 기법을 통

6장: 비지도 학습 알고리즘 군집화 기법: k-평균, 계층적 군집화 차원 축소: PCA, t-SNE 비지도 학습의 활용 사례 모델 평가와 시각화 방법ChatGPT

6장: 비지도 학습 알고리즘

1. 군집화 기법: k-평균, 계층적 군집화

- k-평균 (k-Means Clustering):

- 개념: 주어진 데이터를 k개의 클러스터로 그룹화하는 비지도 학습 알고리즘.

- 알고리즘: 랜덤하게 선택한 중심점에서 시작하여 각 데이터 포인트를 가장 가까운 중심점에 할당하고, 중심점을 업데이트하여 클러스터를 반복적으로 최적화.

- 특징: 간단하고 효율적인 알고리즘으로 대규모 데이터셋에 적용 가능.

- 계층적 군집화 (Hierarchical Clustering):

- 개념: 계층적으로 클러스터를 형성하는 알고리즘으로, 유사도나 거리에 기반하여 클러스터를 합침.

- 알고리즘: 병합 군집화(AGNES)와 분할 군집화(DIANA)가 있으며, 각각 클러스터를 합치거나 분할하는 방식으로 동작.

- 특징: 클러스터의 개수를 사전에 지정할 필요가 없으며, 계층적인 구조를 시각화하기에 용이.

2. 차원 축소: PCA, t-SNE

- 주성분 분석 (PCA, Principal Component Analysis):

- 개념: 데이터의 차원을 줄이고 주요한 정보를 보존하는 비지도 학습 알고리즘.

- 알고리즘: 데이터의 공분산 행렬을 계산하여 고유값 분해를 수행하고, 주성분을 추출하여 데이터를 새로운 저차원 공간으로 변환.

- 특징: 데이터의 분산을 최대한 보존하는 방향으로 주성분을 선택하므로 정보 손실을 최소화.

- t-SNE (t-Distributed Stochastic Neighbor Embedding):

- 개념: 고차원 데이터의 구조를 시각화하기 위해 사용되는 비선형 차원 축소 알고리즘.

- 알고리즘: 고차원 데이터 간의 유사도를 확률 분포로 변환하고, 저차원에서의 유사도와의 차이를 최소화하는 방식으로 저차원으로 매핑.

- 특징: 시각적으로 복잡한 구조를 갖는 데이터의 클러스터를 잘 분리하여 시각화할 수 있음.

3. 비지도 학습의 활용 사례

- 고객 세분화: 고객들을 비슷한 특성을 갖는 그룹으로 분류하여 타겟 마케팅 전략 수립.

- 이상 탐지: 정상적인 패턴에서 벗어난 이상치를 탐지하여 보안, 금융 등 다양한 분야에서 적용.

- 추천 시스템: 사용자의 행동 패턴에 기반하여 상품이나 콘텐츠를 추천하는데 활용.

- 이미지 및 음성 처리: 고차원 데이터를 저차원으로 축소하여 효율적인 처리 및 분석에 활용.

4. 모델 평가와 시각화 방법

- 군집화 평가: 군집 내 유사성 측정, 군집 간 거리 측정, 실루엣 분석 등을 사용하여 군집화 품질을 평가.

- 차원 축소 평가: 정보 보존 비율, 누적 설명된 분산 등을 사용하여 차원 축소의 효과를 평가.

- 시각화: 군집화 결과 및 차원 축소된 데이터를 시각화하여 데이터의 구조를 파악하고 해석 가능한 형태로 변환.

이 장에서는 데이터의 구조를 탐색하고 이해하기 위해 사용되는 비지도 학습 알고리즘과 그 활용 사례를 다룹니다. 또한 각 알고리즘의 결과를 평가하고 시각화하는 방법을 소개하여 데이터 분석 및 모델링 과정을 더욱 효과적으로 수행할 수 있도록 돕습니다.

7장: 모델 평가 및 선택 교차 검증의 이해와 활용 과적합과 과소적합 방지 방법 하이퍼파라미터 튜닝 기법 모델 선택 기준과 방법ChatGPT

7장: 모델 평가 및 선택

1. 교차 검증의 이해와 활용

- 교차 검증 (Cross-Validation):

- 개념: 데이터를 여러 번 반복하여 나누어 모델을 학습하고 평가하는 방법.

- 목적: 모델의 일반화 성능을 평가하고, 편향 및 분산을 줄이며, 데이터를 효율적으로 활용.

- 주요 기법:

- k-겹 교차 검증 (k-Fold Cross-Validation): 데이터를 k개의 폴드로 나누고 각 반복에서 하나의 폴드를 검증 세트로 사용하여 모델을 학습하고 나머지를 학습 세트로 사용.

2. 과적합과 과소적합 방지 방법

- 과적합 (Overfitting):

- 개념: 모델이 학습 데이터에 너무 맞춰져 새로운 데이터에 대한 일반화 성능이 저하되는 현상.

- 방지 방법:

- 규제 (Regularization): 가중치에 대한 패널티를 부여하여 모델의 복잡도를 줄임 (예: L1, L2 규제).

- 조기 종료 (Early Stopping): 검증 데이터의 성능이 향상되지 않을 때 학습을 조기에 중단.

- 과소적합 (Underfitting):

- 개념: 모델이 학습 데이터를 충분히 학습하지 못해 새로운 데이터에 대한 성능이 낮은 현상.

- 방지 방법:

- 모델의 복잡도 증가: 모델의 복잡도를 증가시켜 학습 데이터에 더 잘 맞춤.

- 특성 추가: 더 많은 특성을 사용하여 모델의 표현력을 향상.

3. 하이퍼파라미터 튜닝 기법

- 그리드 서치 (Grid Search):

- 개념: 하이퍼파라미터 조합을 지정된 그리드로 탐색하여 최적의 조합을 찾는 기법.

- 장점: 모든 하이퍼파라미터 조합을 탐색하기 때문에 최적의 조합을 찾을 수 있음.

- 단점: 탐색 공간이 커질수록 계산 비용이 증가.

- 랜덤 서치 (Random Search):

- 개념: 랜덤하게 하이퍼파라미터 조합을 선택하여 탐색하는 기법.

- 장점: 탐색 공간을 더 효율적으로 탐색하며, 계산 비용이 그리드 서치보다 낮음.

- 단점: 최적의 하이퍼파라미터를 찾지 못할 가능성이 있음.

4. 모델 선택 기준과 방법

- 평가 지표 (Evaluation Metrics):

- 분류 모델: 정확도, 정밀도, 재현율, F1 스코어, ROC AUC 등.

- 회귀 모델: 평균 제곱 오차 (MSE), 평균 절대 오차 (MAE), R-squared 등.

- 도메인 지식 (Domain Knowledge):

- 특성 중요도: 도메인 지식을 바탕으로 모델이 어떤 특성을 중요하게 생각하는지 확인.

- 가설 검증: 모델이 만든 가설이 도메인 지식과 일치하는지 확인.

- 시간 및 자원 제약:

- 모델 학습 및 예측 시간: 모델의 학습 및 예측에 필요한 시간을 고려하여 선택.

- 자원 제약: 사용 가능한 하드웨어 자원을 고려하여 모델을 선택.

이 장에서는 모델의 평가와 선택에 필요한 다양한 기법과 방법을 다룹니다. 교차 검증을 통해 모델의 일반화 성능을 평가하고, 과적합과 과소적합을 방지하기 위한 방법을 학습합니다. 또한 하이퍼파라미터 튜닝 및 모델 선택 기준을 통해 최적의 모델을 선택하는 방법을 익힙니다.

8장: 신경망의 기본 퍼셉트론: 단층 신경망의 이해 다층 퍼셉트론: 깊이 있는 신경망의 구조 활성화 함수: 시그모이드, ReLU, 타난 역전파 알고리즘: 학습 과정의 이해ChatGPT

3부: 딥러닝의 세계

8장: 신경망의 기본

1. 퍼셉트론: 단층 신경망의 이해

- 개념: 하나의 선형 분류기로, 입력값에 가중치를 곱한 후 활성화 함수를 통과시켜 출력값을 계산하는 모델.

- 구조: 하나의 입력층과 하나의 출력층으로 이루어져 있음.

- 활성화 함수: 주로 단위 계단 함수를 사용.

2. 다층 퍼셉트론: 깊이 있는 신경망의 구조

- 개념: 여러 개의 은닉층을 추가하여 복잡한 비선형 패턴을 학습할 수 있는 신경망.

- 구조: 입력층, 은닉층, 출력층으로 이루어져 있음.

- 활성화 함수: 시그모이드, ReLU, tanh 등 비선형 활성화 함수를 사용하여 비선형성을 추가.

3. 활성화 함수: 시그모이드, ReLU, 타난

- 시그모이드 함수 (Sigmoid Function):

- 특징: 0과 1 사이의 값을 출력하는 S 모양의 곡선 함수.

- 활용: 이진 분류 문제의 출력층에서 주로 사용.

- ReLU 함수 (Rectified Linear Unit Function):

- 특징: 입력이 0보다 작을 때는 0을 출력하고, 그 외에는 입력 값을 그대로 출력하는 선형 함수.

- 장점: 학습이 빠르고 구현이 간단하여 주로 은닉층의 활성화 함수로 사용.

- 하이퍼볼릭 탄젠트 함수 (Hyperbolic Tangent Function, tanh):

- 특징: -1과 1 사이의 값을 출력하는 S 모양의 곡선 함수.

- 활용: 시그모이드 함수와 유사하게 사용되며, 출력 범위가 더 크므로 시그모이드보다는 선호됨.

4. 역전파 알고리즘: 학습 과정의 이해

- 개념: 신경망의 가중치를 조정하여 출력값과 실제값 사이의 오차를 최소화하는 학습 알고리즘.

- 과정: 순전파를 통해 출력값을 계산하고, 역전파를 통해 오차를 역전파하여 각 가중치를 조정.

- 핵심 요소: 경사 하강법을 사용하여 오차를 최소화하는 방향으로 가중치를 업데이트.

이 장에서는 신경망의 기본 개념과 구조를 이해하고, 다양한 활성화 함수와 역전파 알고리즘에 대해 학습합니다. 퍼셉트론부터 다층 퍼셉트론까지의 발전 과정을 살펴보며, 각 구성 요소의 역할과 의미를 깊이 이해합니다.

9장: 딥러닝 프레임워크 텐서플로우 소개: 설치와 기본 사용법 파이토치 소개: 설치와 기본 사용법 기본 예제와 실습: 간단한 모델 구현 주요 함수와 라이브러리 소개ChatGPT

9장: 딥러닝 프레임워크

1. 텐서플로우 소개: 설치와 기본 사용법

- 개요: 구글에서 개발한 오픈소스 머신러닝 및 딥러닝 라이브러리.

- 설치: pip 또는 conda를 통해 설치 가능 (

pip install tensorflow). - 기본 사용법:

- 텐서 (Tensor): 다차원 배열로 데이터를 표현하는 기본 자료형.

- 그래프 (Graph): 연산들의 집합으로, 텐서플로우에서 연산을 수행하는 방법을 정의.

- 세션 (Session): 그래프 내의 연산을 실행하고, 텐서의 값을 계산하는 데 사용.

2. 파이토치 소개: 설치와 기본 사용법

- 개요: Facebook에서 개발한 오픈소스 머신러닝 및 딥러닝 라이브러리.

- 설치: pip 또는 conda를 통해 설치 가능 (

pip install torch). - 기본 사용법:

- 텐서 (Tensor): 다차원 배열로 데이터를 표현하는 기본 자료형.

- Autograd: 자동 미분 엔진으로, 텐서의 연산 기록을 추적하여 자동으로 역전파를 수행.

- 신경망 모듈 (nn.Module): 딥러닝 모델을 정의하는데 사용되는 추상 클래스.

3. 기본 예제와 실습: 간단한 모델 구현

- 예제: 간단한 선형 회귀 모델을 구현하고 학습하는 과정을 다룸.

- 기본 예제와 실습: 간단한 모델 구현

텐서플로우 예제 코드:

python 코드

import tensorflow as tf

데이터 준비

x_train = [1, 2, 3, 4]

y_train = [2, 4, 6, 8]

모델 정의

model = tf.keras.Sequential([

tf.keras.layers.Dense(units=1, input_shape=[1])

])

모델 컴파일

model.compile(optimizer=’sgd’, loss=’mse’)

모델 학습

model.fit(x_train, y_train, epochs=100)

예측

print(model.predict([5]))

파이토치 예제 코드:

python코드 복사

import torch

데이터 준비

x_train = torch.tensor([[1], [2], [3], [4]], dtype=torch.float32)

y_train = torch.tensor([[2], [4], [6], [8]], dtype=torch.float32)

모델 정의

model = torch.nn.Linear(1, 1)

손실 함수 및 최적화 알고리즘 정의

criterion = torch.nn.MSELoss()

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

모델 학습

for epoch in range(100):

optimizer.zero_grad()

outputs = model(x_train)

loss = criterion(outputs, y_train)

loss.backward()

optimizer.step()

예측

print(model(torch.tensor([[5]], dtype=torch.float32)))

4. 주요 함수와 라이브러리 소개

- 텐서플로우:

tf.keras,tf.data,tf.nn,tf.losses,tf.optimizers등. - 파이토치:

torch.nn,torch.optim,torch.utils.data,torch.autograd,torchvision등.

이 장에서는 딥러닝 프레임워크인 텐서플로우와 파이토치의 기본적인 사용법과 간단한 모델 구현을 다룹니다. 또한 주요 함수와 라이브러리에 대해 소개하여 딥러닝 모델을 구축하고 학습하는 데 필요한 도구를 제공합니다.

10장: 합성곱 신경망 (CNN)

1. CNN의 기본 구조: 합성곱, 풀링, 완전 연결층

- 합성곱층 (Convolutional Layer):

- 개요: 이미지에서 특징을 추출하는 역할을 담당하는 층.

- 구조: 필터(커널)를 사용하여 입력 이미지에 합성곱 연산을 수행하고, 특징 맵을 생성.

- 풀링층 (Pooling Layer):

- 개요: 특징 맵의 크기를 줄이고 계산량을 감소시키는 역할을 담당하는 층.

- 구조: 최대 풀링(Max Pooling) 또는 평균 풀링(Average Pooling) 등의 연산을 통해 특징 맵을 다운샘플링.

- 완전 연결층 (Fully Connected Layer):

- 개요: 특징 맵을 일차원 벡터로 변환하고, 분류기 역할을 수행하는 층.

- 구조: 다차원의 특징 맵을 평탄화하여 입력으로 받아들이는 밀집층(Dense Layer).

2. CNN의 원리와 동작 방식

- 합성곱 연산의 원리:

- 개요: 필터를 이용하여 입력 이미지를 스캔하고, 각 위치에서 필터와 입력값의 곱을 더해 특징 맵을 생성.

- 특징: 지역적 정보를 보존하며, 공간적 계층 구조를 학습할 수 있음.

- 풀링 연산의 원리:

- 개요: 주어진 영역의 대표값(최대값 또는 평균값)을 추출하여 특징 맵의 크기를 줄임.

- 특징: 공간적 크기를 줄이고 계산량을 감소시킴으로써 과적합을 방지하고 계산 효율성을 향상시킴.

3. 이미지 처리 응용: 이미지 분류, 객체 탐지

- 이미지 분류 (Image Classification):

- 개요: 입력 이미지를 미리 정의된 카테고리 중 하나로 분류하는 작업.

- 응용: 손글씨 인식, 개와 고양이 분류 등.

- 객체 탐지 (Object Detection):

- 개요: 이미지 내에서 객체의 위치와 종류를 찾는 작업.

- 응용: 자율 주행 차량, 보안 검색 등.

4. 대표적인 CNN 모델: LeNet, AlexNet, VGG

- LeNet:

- 개요: 손글씨 숫자를 분류하는 데 사용되는 최초의 CNN 모델.

- 특징: 합성곱층과 풀링층이 번갈아 가며 쌓인 구조.

- AlexNet:

- 개요: 2012년 ILSVRC 대회에서 우승한 딥러닝 모델.

- 특징: 다양한 크기의 필터와 드롭아웃 등의 기술을 사용하여 성능을 향상.

- VGG:

- 개요: 매우 깊은 네트워크 구조를 사용한 모델.

- 특징: 3×3 크기의 작은 필터를 사용하여 깊이를 증가시키고 모델을 단순화함으로써 성능을 향상.

이 장에서는 합성곱 신경망의 기본 구조와 원리를 이해하고, 이미지 처리 응용 분야에서의 활용 방법을 살펴봅니다. 또한 LeNet, AlexNet, VGG와 같은 대표적인 CNN 모델에 대해 소개하여 딥러닝 기반의 이미지 분류 및 객체 탐지에 대한 이해를 높입니다.

11장: 순환 신경망 (RNN) RNN의 구조와 원리: 순환과 메모리 셀 시계열 데이터 처리: 주가 예측, 자연어 처리 LSTM과 GRU: 장단기 메모리와 게이트 구조 RNN의 응용 사례: 텍스트 생성, 번역ChatGPT

11장: 순환 신경망 (RNN)

1. RNN의 구조와 원리: 순환과 메모리 셀

- 개요: 순환 신경망은 순차적인 데이터를 처리하기 위해 설계된 신경망 구조.

- 순환 구조: 이전 시간 단계의 출력이 다음 시간 단계의 입력으로 사용되는 구조.

- 메모리 셀: RNN의 핵심 구성 요소로, 이전 상태의 정보를 저장하고 새로운 입력과 결합하여 출력을 생성.

2. 시계열 데이터 처리: 주가 예측, 자연어 처리

- 주가 예측: 과거 주가 데이터를 기반으로 미래 주가를 예측하는 작업.

- 자연어 처리: 문장, 문서 등의 텍스트 데이터를 처리하고 해석하는 작업.

3. LSTM과 GRU: 장단기 메모리와 게이트 구조

- LSTM (Long Short-Term Memory):

- 개요: RNN의 장기 의존성 문제를 해결하기 위해 제안된 구조.

- 특징: 입력, 삭제, 출력 게이트를 사용하여 정보를 저장하고 삭제함으로써 장기 의존성을 관리.

- GRU (Gated Recurrent Unit):

- 개요: LSTM의 간소화된 버전으로, 적은 수의 게이트를 사용하여 구현.

- 특징: 업데이트 게이트와 리셋 게이트를 사용하여 기존 메모리의 상태를 유지하고 새로운 정보를 통합.

4. RNN의 응용 사례: 텍스트 생성, 번역

- 텍스트 생성: 주어진 초기 텍스트를 기반으로 다음 단어나 문자를 예측하여 새로운 텍스트를 생성하는 작업.

- 번역: 한 언어에서 다른 언어로의 문장을 번역하는 작업.

이 장에서는 순환 신경망의 구조와 원리를 이해하고, 시계열 데이터 처리와 자연어 처리에 대한 활용 방법을 살펴봅니다. 또한 LSTM과 GRU와 같은 발전된 RNN 구조를 소개하여 장기 의존성 문제를 해결하는 방법을 배우고, 텍스트 생성과 번역과 같은 다양한 응용 사례에 대해 알아봅니다.

12장: 프로젝트 1 – 이미지 분류 데이터셋 소개: CIFAR-10, MNIST 데이터 전처리 및 준비 CNN 모델 설계 및 구현 모델 학습과 성능 평가 성능 개선 방법ChatGPT

4부: 실전 프로젝트

12장: 프로젝트 1 – 이미지 분류

1. 데이터셋 소개: CIFAR-10, MNIST

- CIFAR-10:

- 개요: 10개의 클래스로 구성된 32×32 크기의 이미지 데이터셋.

- 클래스: 비행기, 자동차, 새, 고양이, 사슴, 개, 개구리, 말, 배, 트럭.

- MNIST:

- 개요: 손으로 쓴 숫자(0~9)로 구성된 28×28 크기의 흑백 이미지 데이터셋.

2. 데이터 전처리 및 준비

- 전처리: 이미지 데이터를 정규화하고, 필요에 따라 크기를 조정하고 데이터를 증강할 수 있음.

- 준비: 데이터를 학습, 검증 및 테스트 세트로 분할하여 모델 학습에 사용.

3. CNN 모델 설계 및 구현

- 모델 설계: 합성곱층, 풀링층, 완전 연결층 등을 조합하여 이미지 분류를 위한 CNN 모델을 설계.

- 구현: TensorFlow 또는 PyTorch를 사용하여 모델을 구현.

4. 모델 학습과 성능 평가

- 학습: 학습 데이터를 사용하여 모델을 학습시키고, 검증 데이터를 사용하여 성능을 평가.

- 평가: 테스트 데이터를 사용하여 모델의 일반화 성능을 평가하여 정확도를 계산.

5. 성능 개선 방법

- 하이퍼파라미터 튜닝: 학습률, 배치 크기, 에포크 수 등의 하이퍼파라미터를 조정하여 성능을 향상.

- 모델 변경: 다양한 모델 구조를 시도하고, 층의 개수나 뉴런의 수 등을 조정하여 성능을 개선.

- 데이터 증강: 이미지 회전, 이동, 반전 등의 기법을 사용하여 학습 데이터를 증강하여 성능을 향상.

이 프로젝트에서는 CIFAR-10 또는 MNIST 데이터셋을 사용하여 이미지 분류 모델을 구현하고 학습합니다. 데이터 전처리, 모델 설계, 학습 및 평가를 진행하고, 최종적으로 모델의 성능을 개선하기 위한 다양한 방법을 탐구합니다.

13장: 프로젝트 2 – 자연어 처리 텍스트 데이터 전처리: 토큰화, 정규화 감성 분석 모델 구현: 데이터셋 소개, 모델 설계 모델 학습과 평가 결과 분석 및 성능 향상ChatGPT

13장: 프로젝트 2 – 자연어 처리

1. 텍스트 데이터 전처리: 토큰화, 정규화

- 토큰화: 텍스트를 단어 또는 문장으로 분할하여 토큰으로 만드는 과정.

- 정규화: 텍스트를 정규 형식으로 변환하여 일관된 표현을 유지하는 과정.

2. 감성 분석 모델 구현: 데이터셋 소개, 모델 설계

- 데이터셋 소개: 감성 분석을 위한 텍스트 데이터셋을 소개하고, 긍정적인 또는 부정적인 감성을 가진 문장으로 구성됨.

- 모델 설계: 임베딩 층, 순환층(RNN 또는 LSTM), 출력층으로 구성된 감성 분석 모델을 설계.

3. 모델 학습과 평가

- 학습: 학습 데이터를 사용하여 감성 분석 모델을 학습시키고, 검증 데이터를 사용하여 성능을 평가.

- 평가: 테스트 데이터를 사용하여 모델의 성능을 평가하여 정확도를 계산.

4. 결과 분석 및 성능 향상

- 결과 분석: 모델의 성능 및 예측 결과를 분석하여 모델의 강점과 약점을 파악.

- 성능 향상: 하이퍼파라미터 튜닝, 모델 변경, 데이터 증강 등의 방법을 사용하여 모델의 성능을 향상.

이 프로젝트에서는 자연어 처리를 위한 감성 분석 모델을 구현하고 학습합니다. 텍스트 데이터의 전처리 과정부터 모델의 설계, 학습 및 평가를 진행하며, 마지막으로 모델의 결과를 분석하고 성능을 향상시키기 위한 방법을 탐구합니다.

14장: 프로젝트 3 – 강화 학습 강화 학습의 기본 개념: 에이전트, 환경, 보상 Q-러닝과 심층 Q-러닝 이해 간단한 게임 AI 구현: 환경 설정, 에이전트 설계 성능 평가 및 개선ChatGPT

14장: 프로젝트 3 – 강화 학습

1. 강화 학습의 기본 개념: 에이전트, 환경, 보상

- 에이전트 (Agent): 의사 결정을 하는 주체로, 강화 학습 알고리즘을 구현한 프로그램.

- 환경 (Environment): 에이전트가 상호 작용하는 외부 시스템 또는 상황.

- 보상 (Reward): 에이전트가 취한 행동에 대한 피드백으로, 얼마나 잘 수행했는지를 나타냄.

2. Q-러닝과 심층 Q-러닝 이해

- Q-러닝 (Q-Learning): 상태-행동 쌍에 대한 가치를 학습하여 최적의 행동을 선택하는 간단한 강화 학습 알고리즘.

- 심층 Q-러닝 (Deep Q-Learning): 심층 신경망을 사용하여 Q 함수를 근사하는 방법.

3. 간단한 게임 AI 구현: 환경 설정, 에이전트 설계

- 환경 설정: OpenAI Gym 라이브러리를 사용하여 간단한 게임 환경을 설정.

- 에이전트 설계: Q-러닝 또는 심층 Q-러닝 알고리즘을 구현하여 에이전트를 설계.

4. 성능 평가 및 개선

- 성능 평가: 학습된 에이전트를 사용하여 게임을 실행하고, 성능을 평가하여 보상을 측정.

- 성능 개선: 하이퍼파라미터 튜닝, 네트워크 구조 변경, 경험 재생 등의 방법을 사용하여 성능을 향상시킴.

이 프로젝트에서는 강화 학습의 기본 개념을 이해하고, Q-러닝 또는 심층 Q-러닝을 사용하여 간단한 게임 AI를 구현합니다. 에이전트와 환경을 설정하고, 학습을 통해 최적의 전략을 찾아 성능을 평가하고 개선하는 방법을 탐구합니다.

15장: 인공지능의 윤리적 문제 개인정보 보호와 보안 문제 알고리즘의 편향성과 공정성 인공지능의 투명성과 설명 가능성 윤리적 인공지능 개발을 위한 가이드라인ChatGPT

5부: 인공지능의 윤리와 미래

15장: 인공지능의 윤리적 문제

1. 개인정보 보호와 보안 문제

- 개요: 인공지능 기술의 발전으로 개인정보가 노출되고 보안 위협이 증가하고 있음.

- 보호 방안: 강화된 보안 및 암호화 기술의 도입, 개인정보 보호법 준수 등.

2. 알고리즘의 편향성과 공정성

- 개요: 알고리즘은 학습 데이터에 내재된 편향으로 인해 공정하지 않은 결정을 내릴 수 있음.

- 해결 방안: 다양성 있는 학습 데이터의 수집 및 균형있는 데이터셋 구성, 공정성을 검증하는 평가 기준 도입 등.

3. 인공지능의 투명성과 설명 가능성

- 개요: 블랙박스로 인해 인공지능의 의사 결정 과정을 이해하기 어려운 문제가 있음.

- 해결 방안: 설명 가능한 인공지능 모델의 개발, 의사 결정 과정의 투명성을 위한 기록 및 로그 기능 추가 등.

4. 윤리적 인공지능 개발을 위한 가이드라인

- 개요: 윤리적으로 적절한 인공지능을 개발하기 위한 지침과 가이드라인의 필요성이 제기되고 있음.

- 가이드라인 내용: 공정성, 투명성, 책임성, 안전성, 프라이버시 등의 원칙을 담은 가이드라인 도입.

이 장에서는 인공지능의 발전으로 노출되는 윤리적 문제에 대해 다룹니다. 개인정보 보호와 보안, 알고리즘의 편향성과 공정성, 인공지능의 투명성과 설명 가능성 등의 문제를 탐구하고, 윤리적 인공지능 개발을 위한 가이드라인의 필요성을 강조합니다.

16장: 인공지능의 미래 전망 최신 연구 동향: 자율주행, 의료 AI, 생성적 AI 인공지능의 미래 기술 발전 가능성 인공지능의 사회적, 경제적 영향 인공지능과 인간의 협업ChatGPT

16장: 인공지능의 미래 전망

1. 최신 연구 동향: 자율주행, 의료 AI, 생성적 AI

- 자율주행: 자율주행 기술은 계속 발전하고 있으며, 센서 기술의 향상과 딥러닝 알고리즘의 발전으로 더욱 안전하고 효율적인 자율주행 시스템이 개발되고 있음.

- 의료 AI: 의료 분야에서는 의료 이미지 분석, 질병 예측 등을 위한 AI 기술이 활발히 연구되고 있으며, 진단 정확도 향상과 치료 방법 개발에 기여할 것으로 예상됨.

- 생성적 AI: 생성적 AI 기술은 이미지, 음성, 텍스트 등의 생성에 활용되며, 예술, 디자인, 엔터테인먼트 분야에서의 응용이 더욱 확대될 것으로 전망됨.

2. 인공지능의 미래 기술 발전 가능성

- 자기학습 능력 강화: 더욱 강력한 자기학습 알고리즘의 개발로 인공지능의 학습 능력이 향상될 것으로 예상됨.

- 강화학습의 활용: 강화학습을 활용한 새로운 응용 분야의 개척으로 인공지능의 응용 범위가 확장될 것으로 전망됨.

- 다중 모달 AI: 이미지, 음성, 텍스트 등 다양한 형태의 데이터를 효과적으로 처리하는 다중 모달 AI 기술의 발전이 예상됨.

3. 인공지능의 사회적, 경제적 영향

- 사회적 영향: 인공지능 기술의 발전은 사회 구조의 변화를 초래할 수 있으며, 일자리의 구조 변화와 노동 시장의 재편이 예상됨.

- 경제적 영향: 인공지능 기술은 경제 성장과 생산성 향상에 기여할 것으로 예상되며, 새로운 산업과 비즈니스 모델의 등장이 예상됨.

4. 인공지능과 인간의 협업

- 상호 보완적 협업: 인공지능은 인간의 업무를 보조하고 지원함으로써 협업적이고 상호 보완적인 관계를 형성할 것으로 예상됨.

- 창의성과 혁신: 인간과 인공지능의 상호 작용을 통해 창의성과 혁신이 촉진될 것으로 예상되며, 새로운 가치 창출에 기여할 것으로 예상됨.

이 장에서는 인공지능의 미래에 대한 전망을 다룹니다. 최신 연구 동향과 기술 발전 가능성을 살펴보고, 인공지능이 사회와 경제에 미칠 영향을 분석하며, 인간과 인공지능의 협업이 어떻게 진화할 수 있는지에 대해 고찰합니다.

추가 학습 자료: 온라인 강의, 도서, 논문 추천 도서 및 온라인 강의: 초보자부터 고급자까지 AI 커뮤니티 참여 방법: 포럼, 이벤트, 해커톤 코드 예제와 데이터셋: GitHub 저장소 링크ChatGPT

부록: 추가 학습 자료

1. 추천 도서 및 온라인 강의: 초보자부터 고급자까지

- 도서 추천:

- “Deep Learning” by Ian Goodfellow, Yoshua Bengio, and Aaron Courville – 딥러닝의 기본 원리와 수학적 배경을 체계적으로 설명.

- “Pattern Recognition and Machine Learning” by Christopher M. Bishop – 머신러닝의 다양한 알고리즘과 이론을 깊이 있게 다룸.

- “Hands-On Machine Learning with Scikit-Learn, Keras, and TensorFlow” by Aurélien Géron – 실용적인 프로젝트와 예제를 통해 머신러닝과 딥러닝을 학습할 수 있는 책.

- 온라인 강의 추천:

- Coursera – “Deep Learning Specialization” by Andrew Ng – 딥러닝 기초부터 고급 주제까지 다루는 일련의 강의.

- Udacity – “Intro to Machine Learning with PyTorch” – 머신러닝의 기본 개념을 PyTorch를 사용하여 실습 중심으로 배울 수 있는 강의.

- edX – “Artificial Intelligence MicroMasters” by Columbia University – 인공지능의 광범위한 주제를 다루며, 이론과 실습을 겸비한 고급 과정.

2. AI 커뮤니티 참여 방법: 포럼, 이벤트, 해커톤

- 포럼 참여:

- Stack Overflow: 프로그래밍과 기술적인 문제 해결을 위한 질의응답 커뮤니티.

- GitHub Discussions: 특정 프로젝트나 기술에 대한 질문, 토론 및 경험을 나눌 수 있는 플랫폼.

- Reddit, 특히 r/MachineLearning: AI 및 머신러닝 관련 뉴스, 연구, 프로젝트를 공유하는 커뮤니티.

- 이벤트 및 해커톤 참여:

- Kaggle Competitions: 데이터 과학 및 머신러닝 경쟁 참여.

- Local Meetups (e.g., Meetup.com): 지역 커뮤니티가 주최하는 학습 모임, 워크샵 참석.

- Major Conferences: NeurIPS, ICML, CVPR 등의 국제 학술대회 참석.

3. 코드 예제와 데이터셋: GitHub 저장소 링크

- GitHub 저장소:

- TensorFlow GitHub – TensorFlow 공식 리포지토리에서 다양한 예제와 도구 접근.

- PyTorch GitHub – PyTorch의 공식 리포지토리에서 프로젝트와 예제 탐색.

- Awesome Machine Learning – 다양한 프로그래밍 언어로 작성된 머신러닝 관련 자료와 라이브러리를 포함한 커뮤니티 기반 리스트.

이 부록은 인공지능 및 머신러닝 학습에 도움이 되는 자료와 커뮤니티 참여 방법, 유용한 리소스 링크를 제공하여 독자들이 지속적으로 학습하고 네트워킹할 수 있도록